一、简介

在国内很多朋友都想尝试ChatGPT,但是因为种种原因,不是要被割韭菜,就是要自己找门路,耗费时间金钱最后可能白忙活一场。非互联网行业的小伙伴想尝试一下有时候还挺费劲。那何不尝试一下这个低调的国产开源人工智能助手呢,完全免费试用,如果有好显卡甚至还可以亲自部署使用调试呢。

ChatGLM-6B是一个基于General Language Model (GLM)架构的开源对话语言模型,拥有62亿参数,支持中英双语。结合模型量化技术,用户可以在普通消费级显卡上进行本地部署,最低仅需6GB显存(在INT4量化级别下)。ChatGLM-6B采用类似ChatGPT的技术,专注于中文问答和对话场景优化。经过约1T标识符的中英双语训练,以及监督微调、反馈自助、人类反馈强化学习等技术的加持,62亿参数的ChatGLM-6B已能够生成相当符合人类偏好的回答。

二、特色介绍

ChatGLM2-6B是开源中英双语对话模型的第二代版本,保留了初代模型的流畅对话和低门槛部署等优点,并引入了一系列新特性:

- 更强大的性能:ChatGLM2-6B基于初代模型的经验进行了全面升级,采用了GLM的混合目标函数,并进行了大规模的中英标识符预训练和人类偏好对齐训练。评测结果表明,相比初代模型,在多个数据集上的性能大幅提升,显示出在同尺寸开源模型中具有较强的竞争力。

- 更长的上下文:通过FlashAttention技术,ChatGLM2-6B将上下文长度由初代模型的2K扩展到32K,并在对话阶段使用8K的上下文长度训练,允许更多轮次的对话。但当前版本对于单轮超长文档的理解能力有限,将在后续迭代升级中进行优化。

- 更高效的推理:借助Multi-Query Attention技术,ChatGLM2-6B具有更高效的推理速度和更低的显存占用。在官方模型实现下,推理速度相比初代提升了42%,并且在INT4量化下,6GB显存支持的对话长度从1K提升到了8K。

- 更开放的协议:ChatGLM2-6B的权重对学术研究完全开放,同时在填写问卷登记后允许免费商业使用。

对比国内做大模型的,清华的ChatGLM2真的是一股清流,安装、微调也是最简单易用的。

使用了一下,与ChatGPT相比虽有不足,但也完全能够满足日常使用。

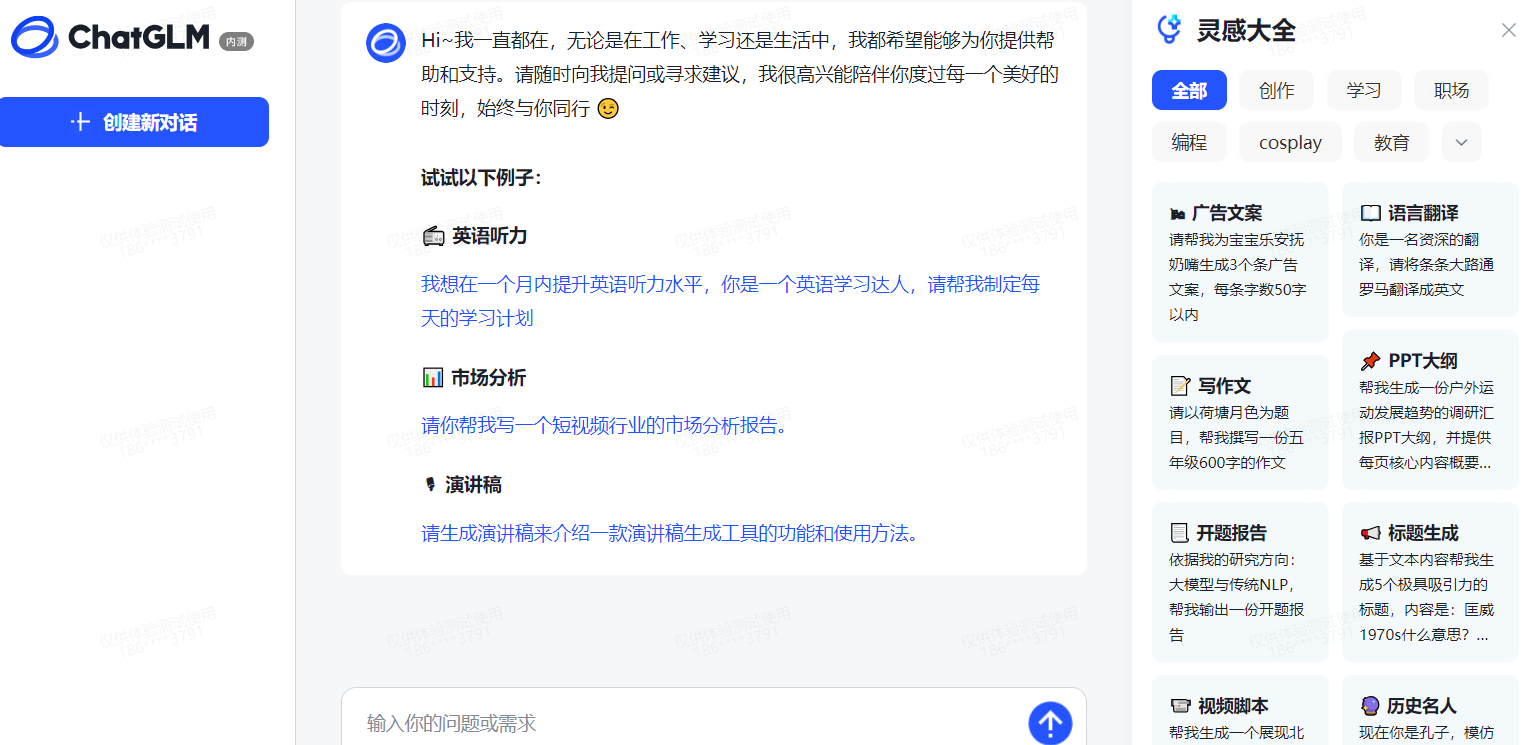

三、使用

直接访问ChatGLM,注册一下,即可免费使用

四、部署

官方提供有详细部署教程,但注意硬件要求

单独部署的好处是可以通过API调用接口使用,官方体验地址打开F12后,会直接卡住,很显然,官方提供的服务不想让人直接破解调用。有兴趣的小伙伴可以试试破解官方的接口。类似pandora做的事情。

对于绝大多数人来说,直接使用官方体验账号是最佳选择。

相关链接

github地址:https://github.com/THUDM/ChatGLM2-6B